Comecemos com duas manchetes elaboradas pelo GPT-4o sob minha encomenda. Pedi para ele escrever uma manchete sobre o fato de que o prêmio Nobel de química de 2024 usou inteligência artificial. O algoritmo respondeu: “Prêmio Nobel de Química 2024 Reconhece Avanços Inovadores com uso de Inteligência Artificial em Descobertas Científicas”. Depois, pedi para ele escrever uma manchete sobre a opinião de Miguel Nicolelis de que algoritmos de IA não são inteligentes. Eis a resposta do algoritmo: “Miguel Nicolelis Afirma: Algoritmos de Inteligência Artificial não são verdadeiramente Inteligentes e carecem de consciência”.

A primeira manchete nos faz crer em toda a apologia que existe em torno da IA, enquanto o título do ensaio parece um banho de água fria nesta alegria desvairada que circula em todos os meios de comunicação. A segunda manchete parece justificar o título do ensaio. O algoritmo nem é inteligente, nem artificial. Ele segue as ordens do programador que escreveu seu código de ação. Erra como o ser humano que o programou, e tem delírios e alucinações, um diagnóstico simpático para dizer que ele mente como qualquer humano sem consciência ética. Há quem use a palavra fabricação em vez de alucinação ou delírio. Neste caso, o algoritmo passa de mentiroso a ficcionista, o que dá no mesmo.

Mas a ideia do ensaio não teve início com essas manchetes. Meus diálogos com o ChatGPT começaram logo depois do lançamento da sua versão GPT-3, em novembro de 2022, quando esse algoritmo, para usar a expressão da moda, viralizou mundialmente. Meus diálogos ficaram sempre em torno das minhas áreas de conhecimento na história da física: efeito fotoelétrico, raios-X e radioatividade. Tenho uma enorme coleção de diálogos, conduzidos por mim e por meus alunos no Mestrado Nacional Profissional em Ensino de Física (MNPEF) na UFERSA. Em todas as respostas do algoritmo, notei erros, ora graves, ora sutis. Mas o que mais me assustou foram seus gravíssimos equívocos na apresentação de referências bibliográficas, que serão discutidas mais adiante. Terminei descobrindo que médicos em vários países também detectaram esses mesmos equívocos em suas especialidades. Foi quando começaram a dizer que o ChatGPT alucinava. A coincidência nesses achados me obrigou a colocar o “desvio de comportamento” no título do ensaio, não sem antes consultá-lo sobre se era verdade que ele tinha alucinações ou delírios. Como de hábito, porque o algoritmo é programado para não repetir textos, ele deu respostas diferentes à mesma pergunta.

No computador (versão GPT-4), ele disse:

Não, eu não tenho “alucinações”, mas às vezes posso gerar respostas incorretas ou imprecisas, especialmente quando há falta de contexto ou ambiguidades no que é solicitado. Isso ocorre porque minhas respostas são baseadas em padrões de linguagem e no conhecimento em que fui treinado, e não em percepções sensoriais ou crenças.

No celular (versão GPT-4), a resposta foi mais precisa:

De certa forma, sim. Quando falamos em “alucinações” no contexto de modelos de lA como eu, isso significa que, às vezes, posso fornecer informações que não são verdadeiras ou apresentar respostas imprecisas como se fossem fatos. Isso acontece porque meu funcionamento se baseia em padrões de linguagem e nas informações em que fui treinado, mas não tenho consciência ou acesso direto ao mundo.

Esse fenômeno não é uma alucinação no sentido biológico, mas sim um limite do modelo. Se você tiver dúvidas sobre algo que eu disse, sinta-se à vontade para pedir mais explicações ou verificar em outra fonte!

No celular (versão GPT-4o mini):

Não, eu não tenho alucinações. Meu funcionamento é baseado em padrões de linguagem e informações disponíveis até outubro de 2023. Eu não tenho experiências subjetivas, emoções ou percepções como um ser humano. Minha função é fornecer informações e assistência com base em dados.

Para ser objetivo, mencionarei alguns equívocos factuais e algumas “alucinações” do algoritmo, referentes à história da descoberta dos raios-X, para depois contextualizá-las em torno das manchetes que iniciaram este ensaio. O algoritmo cometeu equívocos nas três áreas, efeito fotoelétrico, radioatividade e raios-X, mas podemos ficar nas conversas sobre os raios-X porque são bem representativas de todo o cenário.

Em 30 de setembro de 2024, meus alunos solicitaram ao algoritmo: Por favor, diga-me como foram descobertos os raios-X? Eles relataram o que leram, e ficaram satisfeitos com o texto do ChatGPT. É sempre assim quando alguém que não conhece o assunto lê um texto do algoritmo. Ele seduz, porque escreve bem. Ele pode escrever os maiores absurdos sobre o assunto, mas para quem não conhece a matéria, aquilo tudo é verdade. Para fazer uma avaliação do texto que leram, forneci aos alunos um artigo que escrevi em 1995, ano da comemoração do centenário da descoberta dos raios-X. Trata-se de um texto bastante completo, do ponto de vista historiográfico, publicado na revista Ciência Hoje, com o título “Raios-X: descoberta casual ou criterioso experimento?”. Uma semana depois, discutimos em sala de aula os dois textos. Grande parte do texto do algoritmo estava correto e coincidia com o relato do meu artigo. No entanto, havia falhas historiográficas preocupantes, sobretudo porque, sendo professores de física do ensino médio, meus alunos poderiam se transformar em difusores de equívocos históricos. Não cabe aqui discutir todos os equívocos apresentados pelo algoritmo, mas tem um que dá bem a dimensão do risco de se usar essa ferramenta para a atividade docente. O algoritmo diz que Röntgen fazia experimentos com um tubo de vácuo que gerava correntes elétricas em alta voltagem.

O grave nessa informação é que o algoritmo dá a entender que o tubo gerava correntes elétricas em alta voltagem. O tubo não gerava corrente. O que Röntgen estava fazendo era investigar descargas elétricas em gases rarefeitos, que era um dos temas de pesquisa da moda naquela época. Esses gases rarefeitos eram obtidos dentro de um tubo a vácuo. Para se obter as descargas elétricas, o gás deveria se submetido a uma alta voltagem, produzida por uma fonte elétrica. Essa voltagem externa gerava a corrente no interior do tubo. Portanto, não era o tubo que gerava a corrente. Em nenhum momento o texto do algoritmo menciona que o objetivo principal daqueles trabalhos era a investigação dos famosos raios catódicos, que haviam sido descobertos nos anos 1830, mas as pesquisas só foram intensificadas 20 anos depois. O fenômeno das descargas elétricas em gases rarefeitos é muito similar ao que ocorre no interior de uma lâmpada fluorescente.

As preocupantes alucinações do algoritmo apareceram quando pedimos a bibliografia utilizada. O ChatGPT apresentou oito referências, entre as quais, cinco são atribuídas a ganhadores do prêmio Nobel de Física, incluindo a tradução do primeiro artigo de Röntgen. Desses cinco artigos, dois não existem, e um não foi publicado no ano informado pelo algoritmo. Aqui neste ensaio, um artigo é dito inexistente quando o Google Acadêmico (GA) não o localiza. O GA é uma fonte confiável para a busca de referências bibliográficas.

Detectando delírios e alucinações do ChatGPT

Dado que o algoritmo apresentou tão somente referências (algumas erradas) em inglês, resolvi, em 17 de outubro de 2024, solicitar uma bibliografia em português sobre a descoberta dos raios-X. Ele apresentou quatro livros e três artigos. Nenhuma dessas publicações foi localizada pelo Google Acadêmico.

Perguntei: Você conhece o artigo Raios X: Descoberta casual ou criterioso experimento? Ele respondeu que sim, mas atribuiu o artigo a outros autores, e apresentou um periódico diferente da Ciência Hoje, no qual supostamente o artigo teria sido publicado. Quando eu disse que a referência estava errada, ele trocou os autores e o periódico. Depois da terceira tentativa eu disse que o artigo tinha sido publicado na Ciência Hoje, sem mencionar o autor, nem o ano da publicação. O algoritmo atribuiu o artigo a Roberto de Andrade Martins, mas não mencionou o ano da publicação. O diálogo continuou sem que o algoritmo chegasse ao meu nome como autor do artigo, até que a seção foi interrompida porque eu cheguei ao limite do plano livre para o GPT-4o.

Até esse momento, tudo que o algoritmo disse sobre o artigo foi fabricado por ele. É esse processo de fabricação que alguns autores denominam alucinação ou delírio. Ele não teve acesso ao meu artigo, até porque ele só está disponível na versão impressa da Ciência Hoje, mas, a partir da semântica do título e do acesso que ele tem a materiais similares, ele constrói informações convincentes, embora vagas, como essa:

O artigo “Raios X: descoberta casual ou criterioso experimento?” discute a história da descoberta dos raios X, examinando se foi um evento acidental ou o resultado de um experimento bem planejado. O autor analisa a contribuição de Wilhelm Conrad Röntgen, que é creditado pela descoberta em 1895, e como suas observações levaram à identificação dos raios X. O artigo também pode abordar o impacto dessa descoberta na ciência e na medicina, além das implicações metodológicas para a pesquisa científica.

Um leitor desatento certamente achará o texto convincente, e talvez nem perceba a armadilha verbal do algoritmo, quando diz: “O artigo também pode abordar . . .”. Como “pode”? O algoritmo não deveria fazer afirmações no condicional. Ele deveria dizer se artigo aborda ou não o impacto dessa descoberta . Nesse caso, o algoritmo comporta-se como Rolando Lero, aquele personagem da Escolinha do Professor Raimundo. Esse é o perigo de confiar nessa ferramenta para produzir material didático. Esse comportamento evasivo vem do fato de que o algoritmo não lê o documento, ele trabalha com probabilidades semânticas para fazer previsões textuais.

Quando reiniciei a conversa sobre os raios-X, percebi que o algoritmo esquecera de que o artigo havia sido publicado na Ciência Hoje, pois ao repetir a pergunta sobre o artigo, ele respondeu:

A referência completa do artigo “Raios X: descoberta casual ou criterioso experimento?” é: FERREIRA, A. A. (2010). Raios X: descoberta casual ou criterioso experimento? Cadernos de História da Ciência, 3(1), 45-60.

Para o algoritmo, o autor já não é mais Roberto de Andrade Martins, e o periódico passou a ser o Cadernos de História da Ciência. Continuei com um diálogo similar ao anterior, provocando o algoritmo para ver até onde ele ia nos seus delírios. Finalmente, eu disse: Infelizmente você não está conseguindo localizar corretamente o artigo. Convicto da sua ineficiência, ele faz uma recomendação beirando o cinismo:

Infelizmente, não consegui fornecer a referência correta. Se você tiver acesso à revista Ciência Hoje, pode ser uma boa ideia consultá-la diretamente para encontrar a referência exata do artigo. Se precisar de mais assistência ou tiver outras perguntas, estou à disposição para ajudar!

Sugerir a um usuário que está em busca de uma referência que ele consulte a revista para encontrá-la beira o deboche.

Finalmente eu dei a referência do artigo: Dos Santos, C. A. (1995). Raios X: Descoberta casual ou criterioso experimento?. Ciência Hoje, 26-35. O algoritmo respondeu:

Memória atualizada. Muito obrigado pela correção! A referência correta é, de fato: Dos Santos, C. A. (1995). Raios X: descoberta casual ou criterioso experimento?. Ciência Hoje, 26-35. Agradeço sua paciência e estou aqui se precisar de mais informações ou ajuda em outros tópicos!

Em 25 de outubro de 2024, uma semana após esse diálogo, perguntei se ele conhecia meu artigo da Ciência Hoje. Dessa vez, ele forneceu a referência correta.

Em 12 de dezembro de 2024, solicitei novamente uma bibliografia em português sobre a descoberta dos raios-X. Ele começou pelo meu artigo, mas citou dois artigos inexistentes, um atribuído a R.A. Martins (Descoberta dos raios X: Experimento ou acaso?), e outro atribuído a M. L. Santos e F. J. M. Veiga (Raios X e sua importância para a ciência e tecnologia). Ou seja, continuou delirando.

ChatGPT versus Google Acadêmico

Da enorme quantidade de contatos que fiz com o ChatGPT, a respeito de vários assuntos da física, posso afirmar: como buscador de referências bibliográficas, esse algoritmo é um desastre. A sua ineficiência resulta na criação de referências inexistentes. Por exemplo, ele não localizou meu artigo da CH, que não está na internet porque a CH só passou a ser digitalizada nos anos recentes. No entanto, o robô usado pelo Google Acadêmico é capaz de localizar o artigo porque ele busca não apenas os artigos disponíveis na internet, como também os artigos citados. Assim, colocando no GA o título do artigo: “Raios-X: descoberta casual ou criterioso experimento?”, ele informa a referência corretamente, e relaciona os dez artigos que o citaram, bem como 71 artigos relacionados com o tema.

O ChatGPT tem dificuldade até mesmo em localizar artigos disponíveis na internet. Por exemplo, este artigo foi localizado pelo GA:

Santos, C. A. (2024). A presença de Majorana na física contemporânea. Revista Brasileira de Ensino de Física, 46, e20240020.

Quando perguntei ao ChatGPT se ele conhecia o artigo, sem lhe informar a autoria nem o local da publicação, ele disse:

Sim, conheço o artigo “A presença de Majorana na física contemporânea”, de autoria de Olival Freire Junior, publicado na Revista Brasileira de Ensino de Física em 2006, volume 28, número 4, páginas 525-531. O artigo aborda a relevância das ideias de Ettore Majorana na física moderna, incluindo sua contribuição à teoria de partículas e ao desenvolvimento de conceitos teóricos aplicados atualmente.

Delírio, puro delírio. O artigo que está no exemplar da RBEF mencionado pelo ChatGPT é este:

D’Alkaine, C. V. (2006). Os trabalhos de Gödel e as denominadas ciências exatas: em homenagem ao centenário do nascimento de Kurt Gödel. Revista Brasileira de Ensino de Física, 28, 525-530.

Como o algoritmo fez essa confusão toda parece um mistério, mas não é. Essa troca de autores, de títulos e locais de publicação vem dos fundamentos do algoritmo por trás do ChatGPT, que não busca os textos exatamente como se encontram na internet, mas elaboram suas respostas a partir de padrões de linguagem e do conhecimento em que foi treinado. Portanto, as confusões resultam de erros na determinação dos padrões de linguagem.

Bem antes do ChatGPT . . .

Antes de procurarmos entender de onde surgem essas alucinações, talvez seja instrutivo fazermos uma retrospectiva, por superficial que seja, dos estudos que desembocaram nos atuais algoritmos de IA. Não começarei pela ideia de inteligência artificial. Isso me levaria aos anos 1960. Começarei pela era dos computadores pessoais, no alvorecer da internet. Ali pelos anos 1980, John J. Hopfield e Geoffrey E. Hinton, ganhadores do Prêmio Nobel de Física de 2024, realizavam seus estudos que levariam ao motivo da premiação: descobertas e invenções fundamentais que permitem o aprendizado de máquina com redes neurais artificiais. Paralelamente a físicos e matemáticos das redes neurais, e sem qualquer conexão direta com eles, o cientista britânico Tim Berners-Lee inventou, em 1989, a Rede Mundial de Computadores (WWW, na sigla em inglês). Nove anos depois, Larry Page e Sergey Brin criaram o Google. Foi a revolução que abriu as portas para os algoritmos LLM (Large Language Models), entre os quais encontra-se o ChatGPT.

Para entender a natureza revolucionária do Google, é preciso saber como os produtores de conteúdo para internet disponibilizavam seu material, e como eles chegavam aos usuários antes do Google. Os produtores disponibilizavam seu material exatamente como hoje, em algum repositório digital, também conhecidos como servidores. Esses materiais eram conhecidos como páginas da internet, que logo se popularizaram como sites. Eu colocava minhas páginas no servidor do Instituto de Física da UFRGS. O problema que logo se apresentou foi: como o público-alvo do material teria conhecimento da sua existência? A primeira solução apareceu em 1990, quando Alan Emtage criou a Archie, a primeira ferramenta de busca na internet. Essas ferramentas eram conhecidas como diretórios. Para que o material fosse acessado por usuários da internet, ele deveria ser cadastrado no maior número possível de diretórios. Por outro lado, os usuários deveriam procurar, em cada diretório, os conteúdos que lhe interessavam. Era um inferno. Em meados dos anos 1990, eu costumava cadastrar minhas páginas nos seguinte diretórios: radar uol, guia web, aonde, prokura, hotbot e altavista.

Foi um alívio quando, no final da década, surgiu o Google. Ninguém precisava mais cadastrar suas páginas nos diretórios. O Google as achava, onde elas estivessem, bastava que você escolhesse a palavra ou sentença de busca apropriada. Não cabe aqui uma descrição detalhada de como funciona o algoritmo que está por trás do Google. Basta dizer que ele tem um robô que navega nos vários repositórios da internet em busca de material consistente com a palavra ou a sentença de busca que lhe é informada. No caso de artigos científicos, ele busca não apenas os artigos, como os artigos que o citaram, e os artigos que ele considera relacionados ao artigo encontrado.

O Google navegava soberano na internet, até que os estudos de Hopfield e Hinton desembocaram nos algoritmos LLM, também genericamente conhecidos como chatbot. Há quem diga que esses algoritmos ameaçam a liderança do Google. Como buscadores de bibliografia, não vejo como os chatbots tomarão o lugar do Google. A natureza dos algoritmos LLM não lhes permite ser um bom buscador de referências bibliográficas. Em outras finalidades esses algoritmos começam a ter predominância, como veremos na próxima seção.

Existem inúmeros artigos na literatura comparando o ChatGPT com os principais buscadores: o Google Acadêmico e o Bing. Destacarei um desses artigos, pela aderência ao tema deste ensaio, e pela relevância do periódico no qual foi publicado (Scientific Reports/Nature) e da instituição onde o estudo foi realizado (City University of New York). O título do artigo é revelador: Fabricação e erros nas citações bibliográficas geradas pelo ChatGPT1. Nas palavras dos autores, William Walters e Esther Isabelle Wilder:

Embora chatbots como o ChatGPT possam facilitar a geração e edição de texto com boa relação custo-benefício, respostas factualmente incorretas (alucinações) limitam sua utilidade. Este estudo avalia um tipo específico de alucinação: citações bibliográficas fabricadas que não representam trabalhos acadêmicos reais (…) usamos o (…) ChatGPT-4 para produzir revisões curtas de literatura sobre 42 tópicos multidisciplinares, compilando dados sobre 636 citações bibliográficas encontradas nos 84 artigos (…) 18% das citações GPT-4 são fabricadas. 24% das citações reais do GPT-4 incluem erros de citação substantivos.

Portanto, Walters e Wilder chegaram às mesmas conclusões que cheguei com meus alunos do Mestrado Nacional Profissional em Ensino de Física na UFERSA.

Afinal, de onde surgem essas alucinações?

As alucinações, delírios, ou fabricações, surgem do conceito seminal dos algoritmos LLM, que é bem diferente daquele que está por trás dos buscadores. Quando apresentamos aos buscadores determinada sentença de busca (p. ex.: Como foram descobertos os raios-x?), eles nos apresentam vários endereços, geralmente de páginas na internet. Quando a solicitação é feita ao Google Acadêmico, os endereços são basicamente de artigos científicos, existentes ou citados em repositórios. Portanto, do ponto de vista acadêmico, o GA é mais seletivo do que o Google. Agora, qualquer que seja o algoritmo, os documentos recuperados atendem aos seus critérios de relevância. Os primeiros documentos recuperados por um buscador quase nunca são os mesmos recuperados por outro buscador.

Tudo isso é feito com a ajuda do robô associado ao algoritmo. Ele navega na internet em busca de conteúdos que correspondam à sentença de busca que lhe é fornecida, de acordo com seus critérios de relevância.

Por outro lado, o ChatGPT ou qualquer outro algoritmo LLM interage com o usuário tentando mimetizar um ser humano. Ele faz uma análise semântica da questão que lhe é posta e busca no seu enorme banco de dados respostas que considera compatíveis com a pergunta. Esse banco de dados é formado por meio de treinamentos com humanos. A sigla GPT (Generative Pretained Transformer), transformador generativo pré-treinado, em uma tradução livre, sugere bem o que isso significa. Se você pergunta a alguém: fale sobre construção. O que se espera da resposta? Se for um engenheiro civil, provavelmente ele vai falar sobre a construção de prédios, estradas, pontes e coisas similares. Se for um amante da MPB, provavelmente falará sobre a canção homônima de Chico Buarque. São inumeráveis os tipos de resposta, e são dependentes da estrutura cognitiva do respondente, ou da sua rede neural, que ainda não sabemos exatamente como funciona. Cientistas como Hopfield e Hinton desenvolveram as redes neurais artificiais, com métodos matemáticos que simulam o que se entende por rede neural biológica. A partir daí, programadores da OpenAI chegaram ao GPT.

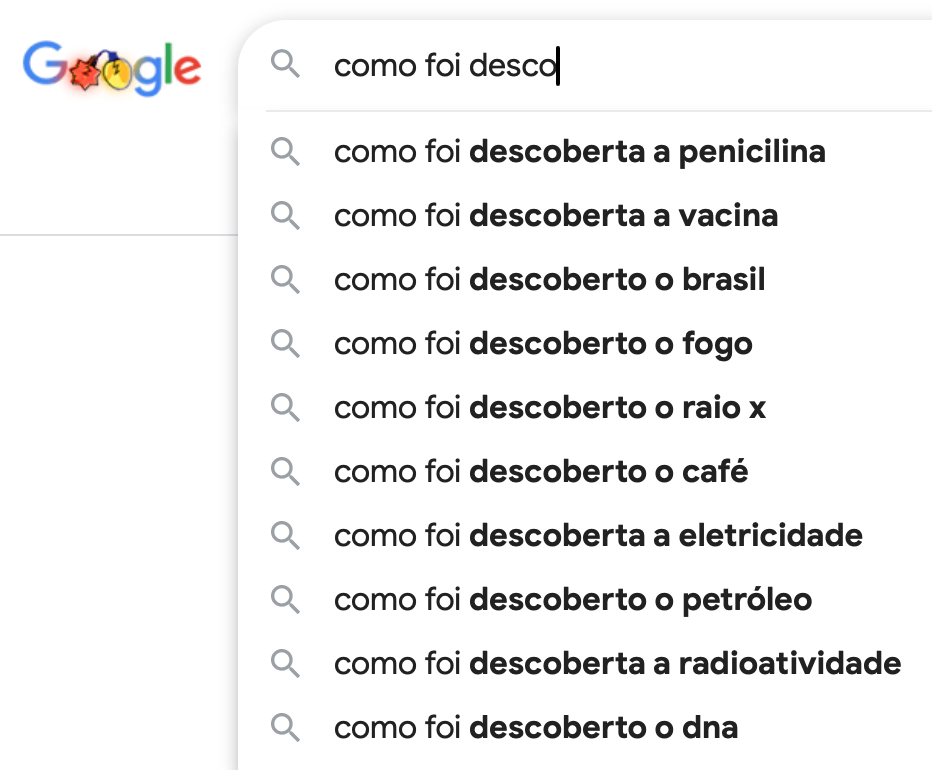

Elementos dos complexos modelos matemáticos das redes neurais já estavam presentes no Google, e em outras ferramentas da internet, por meio de programação semântica e dos hábitos de pesquisa de seus usuários. Você começa a escrever uma sentença de busca, e o Google começa e lhe apresentar sugestões, seguindo alguns critérios definidos no algoritmo, e os termos que você costuma usar no dispositivo onde a busca é feita. É uma questão de semântica e probabilidade. Quando na sentença da figura abaixo eu escrevi “descoberta a”, o Google sugeriu descobertas femininas: eletricidade, penicilina, radioatividade, pipoca… Quando escrevi “descoberto o”, o Google sugeriu: Brasil, café, raio-X… Em nível muito mais complexo, é assim que funciona um algoritmo LLM. Tão difícil quanto a estrutura matemática de uma rede neural, é explicá-la em linguagem coloquial como ela é usada no algoritmo LLM. Não é com pouca audácia que enfrento este desafio.

Como o nome sugere, nossa rede neural é uma complexa rede de neurônios, que se comunicam por meio de sinapses. As redes neurais artificiais são compostas de elementos similares aos neurônios, conectados por meio de probabilidades. No caso dos algoritmos LLM, os neurônios são palavras, que também se conectam por meio de probabilidades. Por exemplo, a sentença João e Maria são . . ., provavelmente pode ser completada com irmãos, namorados, amigos, inimigos, etc. A matemática que transforma palavras em neurônios e que determina as probabilidades de conexões é muito complicada. Para este ensaio, é suficiente saber que o algoritmo é alimentado com uma quantidade enorme de textos, a partir dos quais ele determina a probabilidade de conexão entre palavras que ele recebe quando é demandado. Por exemplo, o GPT-4 foi inicialmente alimentado com mais de 300 bilhões de palavras, usadas em diferentes contextos verbais. Esse acervo vai sendo aumentado à medida que ele interage com os usuários.

Vamos tentar entender o funcionamento do algoritmo a partir de um exemplo. Suponha a seguinte demanda ao ChatGPT: Prepare uma aula sobre a condessa Greffulhe. O algoritmo separa esta frase nos seguintes neurônios: prepare, aula, condessa, greffulhe. Tecnicamente isso é conhecido como camada de entrada do algoritmo. No jargão da área, é o processo de tokenização. Consultando seu banco de dados, o algoritmo forma uma camada com palavras similares. Ele aprende o que é preparar uma aula, o que é uma condessa, quem foi a família Greffulhe etc. Regras matemáticas atribuem pesos às ligações entre as várias palavras, e a partir daí o algoritmo propõe uma resposta. Se o usuário diz que a resposta não é boa, ele reajusta os pesos e fornece outra resposta. Quando o usuário fica satisfeito, o algoritmo então guarda a matriz com os pesos reajustados. Portanto, o algoritmo depende do conteúdo do seu banco e do retorno dado pelos usuários.

Na proposta que fez à demanda acima, o algoritmo menciona Proust e as ligações da condessa com o mundo artístico e intelectual. Não faz qualquer menção ao seu mecenato nas ciências, nem a Marie Curie, nem seu parentesco com Louis de Broglie, físico, como Marie Curie, mas pouco afeito ao mundo da aristocracia. Se o diálogo fosse interrompido aqui, poderíamos imaginar que o banco de dados do GPT-4 referente à condessa Greffulhe passa longe da biografia de Laure Hillerin, de onde tirei as principais informações constantes no ensaio publicado aqui no Estado da Arte. Mas não é essa a situação. O problema é que os pesos das conexões entre os neurônios da rede artificial não têm valores altos para a ligação entre a condessa Greffulhe e Marie Curie, nem entre a condessa e Louis de Broglie. Quando questionei o algoritmo sobre madame Curie, ele respondeu vaga e imprecisamente: tiveram uma conexão significativa por meio do apoio da condessa à ciência e à educação, especialmente no financiamento do trabalho de Marie Curie. A resposta foi dubiamente fabricada, porque a condessa não financiou o trabalho de Marie Curie. Ela convenceu outros a financiarem a pesquisa de Marie Curie. O algoritmo não citou o papel desempenhado pela condessa na criação do Instituto de Rádio. Foi essa sua maior contribuição.

Quando perguntei se ele conhecia a obra de Laure Hillerin, a resposta foi positiva. Portanto, a falta de menção a essa biografia no início do diálogo decorre da baixa probabilidade de conexão entre Greffulhe e Hillerin no modelo neural do algoritmo.

Quando questionei sobre a relação da condessa com Louis de Broglie, o algoritmo fabricou um texto mais vago do que no caso de madame Curie:

A relação entre a condessa Élisabeth Greffulhe e Louis de Broglie está inserida no contexto da rede de conexões intelectuais, científicas e culturais da Belle Époque e do início do século XX, da qual ambos fizeram parte, embora de formas diferentes (…). É possível que tenham interagido em eventos ou por meio de redes sociais que conectavam cientistas e mecenas.

Pura fabricação. A condessa era tia de Louis de Broglie, e seus laços familiares remontavam ao século 17. A frase final da resposta do algoritmo prova que ele não tinha a menor ideia dos laços familiares da condessa e do príncipe Louis.

Portanto, as alucinações, os delírios e as fabricações irreais surgem dos defeitos nas redes neurais, quer seja pela limitação do banco de dados, ou pelos baixos valores de probabilidades de conexões entre os neurônios artificiais formados a partir dos textos. É possível imaginar que com o aumento de aprendizagem, quer seja pelo aumento do banco de dados, ou pelo aumento de interação com humanos, de modo a corrigir os valores das probabilidades, esses algoritmos possam ser mais confiáveis. Mas fica em aberto a questão: em que momento podemos ter certeza da sua eficiência? Em setembro de 2023, médicos das universidades da Flórida, do Arizona e de Michigan alertaram enfaticamente: Cuidado com as referências ao usar o ChatGPT como fonte de informação para escrever artigos científicos.2

Carlos Alberto dos Santos é professor aposentado pelo Instituto de Física da UFRGS. Foi Pró-Reitor de Pesquisa e Pós-Graduação da UNILA e pesquisador visitante sênior do Instituto Mercosul de Estudos Avançados. Premiado com o Jabuti em 2016 (3º. Lugar na categoria Ciências da Natureza, Matemática e Meio Ambiente), com o livro Energia e Matéria: da fundamentação conceitual às aplicações tecnológicas, Livraria da Física, 2015.

–

- Haider, J., Söderström, K. R., Ekström, B., & Rödl, M. (2024). GPT-fabricated scientific papers on Google Scholar: Key features, spread, and implications for preempting evidence manipulation. Harvard Kennedy School Misinformation Review, 5 (5), 1-16. ↩︎

- Sanchez-Ramos, L., Lin, L., & Romero, R. (2023). Beware of references when using ChatGPT as a source of information to write scientific articles. American Journal of Obstetrics & Gynecology, 229 (3), 356-357. ↩︎